גזענית ושוביניסטית? האינטליגנציה המלאכותית לא עמדה במבחן

פורסם בתאריך: 06/11/2018, גיליון 1943

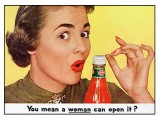

טכנולוגיית הבינה המלאכותית, המבטיחה לחסל את חוסר היעילות שמקורה בהערכות ובהנחות אנושיות סובייקטיביות, מעלה חשש כבד כי היא כוללת הטיות נסתרות. כך למשל, ענקית המסחר המקוון אמזון, הפסיקה לאחרונה להשתמש בתוכנה גיוס עובדים מבוססת אינטליגנציה מלאכותית, משום שהיא הייתה מוטה נגד נשים.

מאחר

שחלק גדול מהעובדים שנשכרו באמצעות שימוש בתוכנה היו גברים, התוכנה נתנה עדיפות

לגברים. גם לאחר שתוקנו הליקויים באלגוריתם, אמזון הפסיקה להשתמש בתוכנה משום שהיה

חשש שהיא מוטה גם בנקודות אחרות.

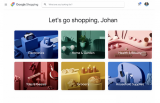

מחקרים אחרים שנערכו בשנים האחרונות גילו הטיה דומה במנוע החיפוש של לינקדאין. לפני כמה שנים הואשמה גוגל בכך שמנוע החיפוש שלה זיהה אישה אפריקאית בתור "גורילה".

"האלגוריתמים אינם מוטים מטבעים", אמר ונקטס סליגרמה, פרופסור מהמחלקה להנדסת חשמל ומחשבים מאוניברסיטת בוסטון. אל לדבריו, הם נוטים להתבסס על הנתונים הראשוניים שהוכנסו בהם. בנוסף, התוכנות עשויות להסתמך על ההטיות הראשוניות שהוכנסו אליהן על ידי המפתחים. כתוצאה מכך, נתונים של אינטליגנציה מלאכותית עשויים להיות מוטים אפילו יותר מנתונים שנאספו ונותחו על ידי בני אדם.